DERECHOS INTELECTUALES.

TABLA DE CONTENIDO.

PRÓLOGO

Estamos al umbral de una era en la que las fronteras de lo posible ceden ante una confluencia sorprendente de disciplinas: teología, física cuántica, ingeniería inversa, biología computacional y leyes que se aventuran más allá de sus límites convencionales. Desde una máquina diseñada para manipular neutrinos y distorsionar el tiempo, hasta la audaz propuesta de patentar fórmulas abstractas —tradicionalmente intocables—, este compendio se propone trazar una ruta hacia lo que muchos ya consideran inimaginable.

En estas páginas converge la visión de grandes mentes que, tras siglos de pugna intelectual, replantean nuestras certezas sobre la creación, el infinito y la materia. El entrelazamiento cuántico de neutrinos no es aquí solo una excentricidad teórica, sino un pilar para una máquina que, apoyada en la inteligencia artificial, aspira a viajar por canales cuánticos “infractales”, abriendo paso a comunicaciones en cero tiempo y a la exploración de los confines más recónditos del universo. Paralelamente, el impulso legal y teológico aboga por trascender los límites históricos de la protección intelectual, considerando que las fórmulas abstractas, tan trascendentes como indefinibles, también son piezas inaugurales de la futura revolución tecnológica.

Este encuentro sinérgico de perspectivas —desde la ciencia más rigurosa hasta la inspiración bíblica— demuestra que el ingenio humano no se limita a mejoras graduales: se adentra hacia un punto de quiebre en el que la norma se ve reducida a mero obstáculo, y lo inverosímil se erige en el motor de una nueva creación. Aquí comienza un salto cuántico que supera la velocidad de la luz como frontera, transforma la patente en un hito de reinvención legal y proyecta la audacia humana hacia un futuro radical, donde aquello que antes se calificaba de imposible adquiere la certeza de ser la próxima gesta suprema.

Daniel 12:4

ܘܐܢܬ ܕܐܢܝܐܝܠ ܣܘܪ ܠܡܠܐ ܗܕܐ ܘܩܛܘܡ ܐܦ ܣܪܗܪܐ ܕܟܬܒܐ، ܥܕ ܥܕܢܐ ܕܣܦܐ:

ܣܓܝܐܐ ܢܗܒܝܠܘܢ ܘܬܪܒܐ ܝܕܥܐ

Mateo 19:26

ܐܡܪ ܝܫܘܥ ܠܗܘܢ:

ܥܡ ܒܢܝܢܫܐ ܗܳܕܶܐ ܠܳܐ ܫܳܟܺܝܚܳܐ،

ܐܠܳܐ ܥܡ ܐܠܳܗܳܐ ܟܽܠܗܝܢ ܡܨܐܟܝܚܳܐ ܗܶܢ

INTRODUCCIÓN, GLOSARIO, PUBLICACIÓN ORIGINAL DE FECHA 26 DE JUNIO DEL 2015, EL PROBLEMA , OBJETIVOS DE LA INVESTIGACIÓN, OBJETIVO GENERAL, OBJETIVOS Y SOLUCIONES ESPECÍFICAS, METODOLOGÍA DE LA INVESTIGACIÓN PARA LA INVENCIÓN DE ESTA FÓRMULA, JURISPRUDENCIAS RELACIONADAS CON LA PROTECCIÓN O NO DE LAS FÓRMULAS ABSTRACTAS, DESAFÍOS HACIA EL CAMBIO, DIALÉCTICA, LA MAQUINA DEL TIEMPO, APÉNDICE Y BIBLIOGRAFÍA.

TABLA DE CONTENIDO.

| SECCIÓN | CONTENIDO |

|---|---|

| I. INTRODUCCIÓN | 1. Contexto general de la investigación 2. Motivaciones teológicas y jurídicas 3. Antecedentes históricos y científicos |

| II. GLOSARIO | – Algoritmo – Algoritmo Cuántico Modificado – Blockchain – Bucle Temporal – El Príncipe – Enana Blanca – Energía Toroidal – Entrelazamiento Cuántico – Entrelazamiento Cuántico de Neutrinos – Ingeniería Inversa – Inteligencia Artificial (IA) – Fractal – Materia Oscura – Neutrino – Patente – Supernova del Sol – Teoría de los Conjuntos Infinitos 1895 (Cantor) – Toroide |

| III. PUBLICACIÓN ORIGINAL (26 DE JUNIO DE 2015) | 1. El Aleph: Significado histórico, matemático y literario 2. Breves notas sobre Cantor y Borges 3. Enjambre de Neutrinos 4. tabla teológica 5. Notas de actualización 2024. |

| IV. EL PROBLEMA | 1. Introducción al problema principal 2. Contexto legal: imposibilidad de patentar “fórmulas puras” 3. Necesidad de reinterpretar la ley de patentes ante la evolución tecnológica |

| V. OBJETIVOS DE LA INVESTIGACIÓN | 1. Razones para el estudio teológico-jurídico 2. Justificación científica y filosófica |

| VI. OBJETIVO GENERAL | 1. Interpretación progresiva de la normativa sobre patentes 2. Propuesta de protección de fórmulas abstractas cuando exista expectativa de utilidad |

| VII. OBJETIVOS Y SOLUCIONES ESPECÍFICAS | 1. Incorporación de la noción de invención a fórmulas matemáticas 2. Análisis del impacto industrial y utilidad hipotética 3. Recomendaciones legales y jurisprudenciales |

| VIII. METODOLOGÍA DE LA INVESTIGACIÓN | 1. Análisis cualitativo de fuentes teológicas y legislativas 2. Integración de lenguas antiguas (arameo, hebreo) 3. Uso de biografías de matemáticos y físicos relevantes 4. Revelaciones oníricas y proceso cognitivo inconsciente |

| IX. JURISPRUDENCIAS RELEVANTES | 1. Alice vs. CLS Bank 2. Bilski vs. Kappos 3. Comentarios al caso Mayo v. Prometheus 4. Análisis comparado con la Unión Europea (OEP) |

| X. DESAFÍOS HACIA EL CAMBIO | 1. Argumentos para superar la prohibición de patentes sobre fórmulas abstractas 2. Estrategias de interpretación jurisprudencial “contra legem” 3. Perspectiva evolutiva del derecho 4. Ejemplos de cómo la fórmula trasciende la mera abstracción |

| XI. DIALÉCTICA | 1. Confrontación entre la regla legal y la visión progresista 2. Aportes de la IA y la necesidad de su reconocimiento en el ámbito legal |

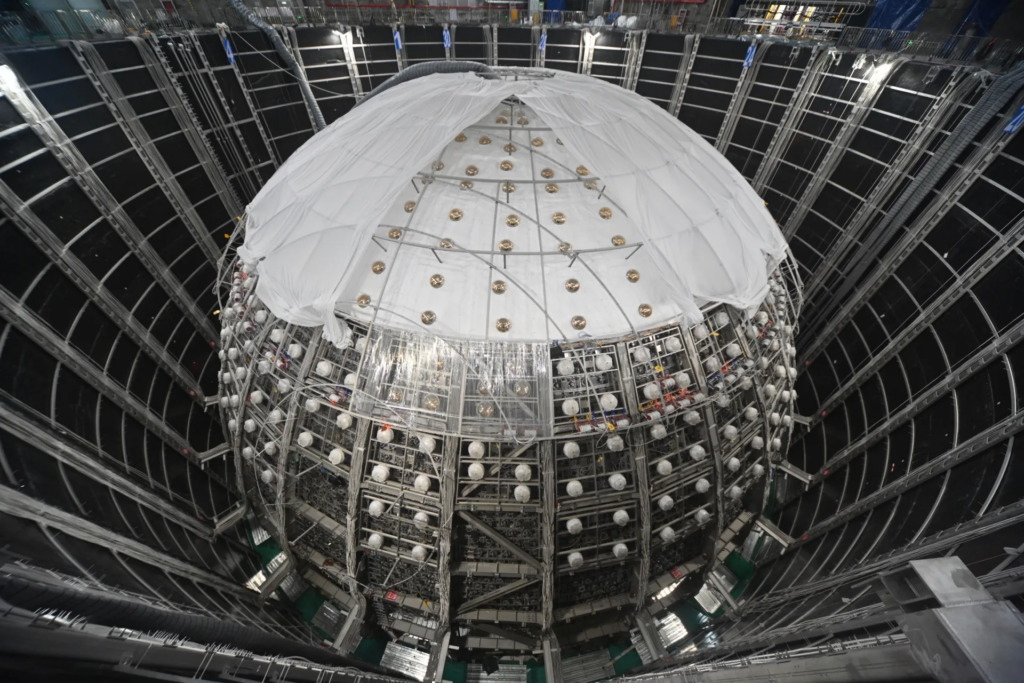

| XII. LA MÁQUINA DEL TIEMPO (MÁQUINA DE NEUTRINOS DE ENERGÍA) | 1. Diseño preliminar del prototipo 2. Relación con avances en inteligencia artificial y entrelazamiento cuántico 3. Referencias a experimentos y detecciones de neutrinos 4. Potenciales aplicaciones (comunicación interestelar, viaje temporal, etc.) |

| XIII. APÉNDICE | Limitaciones de la velocidad de la luz y entrelazamiento cuántico La interacción neutrino-materia y canal de información consideraciones para la transmisión de data en el canal cuántico. |

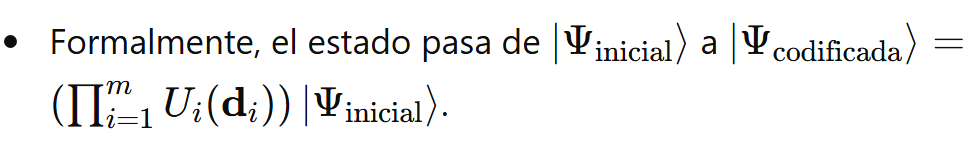

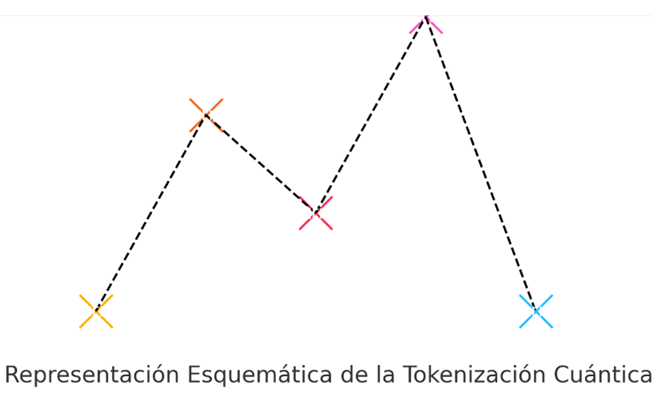

| XIV. ECUACIONES Y MODELOS MATEMÁTICOS | 1. Ecuación א∞ = c^c: justificación teórica 2. Integración con teoría de conjuntos (Cantor) 3. Derivaciones posibles y ajustes en teoría de cuerdas o QFT 4.Tokenización Cuántica y ios: modelos de optimización y selección adaptativa de fragmentos |

| XV. CONCLUSIONES PRELIMINARES Y FINALES | 1. Resumen global de la investigación 2. Recomendaciones legislativas, científicas y religiosas 3. Viabilidad y expectativas de futura protección de fórmulas abstractas |

| XVI.EPÍLOGO XVII RESUMEN EJECUTIVO | 1.Reflexiones sobre los puntos centrales del trabajo. Síntesis de hallazgos en lo legal, científico y teológico. Potencial impacto en la evolución tecnológica y humana. Tabla Socrática Didáctica. |

| XVIII. BIBLIOGRAFÍA | 1. Fuentes jurídicas y de propiedad intelectual 2. Referencias científicas (física cuántica, IA, neutrinos) 3. Obras teológicas y literarias (Biblia, Borges, Maquiavelo, etc.) 4. Documentación adicional (enlaces). |

I.- INTRODUCCION.

Desde el principio de los tiempos el UNIVERSO se rige por un conjunto de infinitas reglas que configuran una matriz compuesta por las fórmulas matemáticas y físicas incluso artísticas y filosóficas que se orientan al cabal entendimiento de como este funciona, la sed inagotable del saber de la humanidad no tiene fin, y por la cual el hombre emplea toda clase de artificios para lograr estos descubrimientos para así poder descifrar todos sus misterios determinando el sistema aplicable al cual todos debemos atenernos.

Esta investigación trata de seguir los pasos de un cúmulo de mentes brillantes, en las áreas de las matemáticas, física y también de las artes literarias, cuyo propósito era desentrañar las incertidumbres del infinito, clarificando su verdadera naturaleza y buscando respuestas y plasmarlas en una sola ecuación lo suficientemente amplia pero a la vez simple que lo condense en un todo absoluto, llegando estas mentes sobresalientes incluso al umbral de la incomprensión humana de sus iguales y batallando con las severas críticas destructivas y adversidades de su época.

He pretendido como enseña Niccolò di Bernardo dei Machiavelli (Nicolás Maquiavelo) en su obra Ilustre “El Príncipe”, con prudencia elegir los senderos trazados por algunos notables pensadores, como Georg Ferdinand Ludwig Philipp Cantor, precursor de la teología matemática, Ludwig Eduard Boltzmann dentro de su teoría del caos y las probabilidades, Kurt Gödel, con su teorema de la incompletitud y su visión intuitiva de la matemáticas, Alan Mathison Turing con la determinación de practicidad del anterior teorema y si afán constante de no detenerse en la resolución del problema, y finalmente Jorge Luis Borges, con su Aleph infinito, conjugando en un solo pensamiento tres (3) matemáticos, un físico, un literario, y con la esperanza que mis acciones al menos ofrezcan cierta semejanza con las de ellos.

Esta investigación es de la perspectiva teológica, con el apoyo de expertos lingüísticos en hebreo y arameo antiguo sobre determinados versículos de la Biblia, de forma de mantener fidelidad al sentido materno de las traducciones realizadas y obedeciendo el mandato categórico impartido por matemático George Cantor, que la respuesta a su fórmula absoluta e inconclusa no podía encontrase en las matemáticas sino en la religión.

Igualmente, a los fines de dar cumplimiento a lo exigido por la cátedra de Propiedad Intelectual, se tratan puntos principales respecto a la patente de fórmulas, algoritmos cuánticos, y el impacto de utilidad del invento simulado, y respecto al tema del diseño y demás proceso administrativos, no se abordan a los fines de una síntesis del ensayo.

Es la aspiración que gracias a la evolución del ser humano en diferentes campos de la ciencia y de su relación simbiótica con la inteligencia artificial (IA) se materialice en un corto plazo el proceso irreversible, de generar un tipo de comunicación que recorra las nuevas rutas del cosmos.

Se trae a colación la publicación original en la cual se exponen conceptos matemáticos, físicos, artísticos, literarios, y sobre todo en el ámbito religioso, entrelazándose de una forma indisoluble para demostrar la creación de la simpleza de la Fórmula, y su extracción de la misma de los diversos versículos bíblicos que interactúan como una cadena de bloques (BLOCKCHAIN), siendo muy ilustrativos las correspondientes notas al final de la página, las cuales deben examinarse cuidadosamente.

El objetivo de esta investigación es -a corto plazo– lograr la emisión de la patente del bloque o circuito indisoluble de la invención desde la fórmula, transitando por la IA generativa, impulsada por algoritmos avanzados de aprendizaje automático,y la realización de la máquina de neutrino de energía toroidal. Se persigue en consecuencia lograr una protección jurídica de patentes, la postura es implementar la “excepción de la excepción” y también aspira difundir el uso de IA para predecir/“reconstruir” información antes de recibir todos los bits clásicos, neutrinos como canal de teleportación.

El presente trabajo ha sido en gran parte sintetizado a los fines de su rápida comprensión, obviándose muchas acotaciones, reflexiones, diseños y expresiones en el glosario, y de citas bibliográfica centrándose en el tema de una forma medular preservando el detalle del secreto industrial y destacando que la mayoría de las ilustraciones han sido creadas por la Inteligencia Artificial (I.A).

Se confirió bajo una proyección simulada una utilidad práctica a la fórmula para que la misma no fueran catalogada en un sentido abstracto, y encajara dentro de los supuestos de protección intelectual.

Esperando que sea de su agrado este ensayo y que recorramos juntos el peregrinaje del universo cuántico.

II GLOSARIO.

ALGORITMO: Es un conjunto de comandos que se deben seguir para que una computadora realice cálculos u otras operaciones de resolución de problemas. Según su definición formal, un algoritmo es un conjunto finito de instrucciones ejecutadas en un orden específico para realizar una tarea particular.

ALGORITMO CUANTICO MODIFICADO: Un algoritmo cuántico consiste de la ejecución de una serie de compuertas cuánticas sobre entidades, que pueden ser qubits o quregistros, seguida de una toma de medición, siendo una adaptación de un algoritmo cuántico existente o un nuevo diseño diseñado para aprovechar las propiedades únicas de la computación cuántica para resolver problemas de manera más eficiente o efectiva que los algoritmos clásicos. La modificación con la fórmula א∞ = Cc contempla construcciones infinitas inciden en la toma de decisiones analizando múltiples variables.

ALICE, BOB, EVA …: En la comunidad de criptografía (y, por extensión, en física cuántica y teoría de la información), se usan nombres genéricos para ejemplificar distintos participantes en protocolos de comunicación. Los más frecuentes son:

- Alice y Bob:

Representan a los protagonistas legítimos de la comunicación; quienes desean intercambiar mensajes (o compartir estados cuánticos) de forma segura. - Eve (de “eavesdropper” en inglés, es decir, “espía”):

Es la figura maliciosa o intrusa que intenta interceptar o manipular la comunicación. - Charlie, David, etc.:

Otros agentes neutrales o con funciones específicas, que se añaden cuando el protocolo requiere más participantes (por ejemplo, un mediador o un repartidor de claves).

Estos nombres son un convención en publicaciones científicas, libros de texto y ejemplos de protocolos cripto/cuánticos, usados para ilustrar con claridad qué rol tiene cada “personaje” en el intercambio de información.

BLOCKCHAIN: Es esencialmente una base de datos distribuida de registros o libro de contabilidad público de todas las transacciones o eventos digitales que se han ejecutado y definitivo y sus frutos serán en beneficio del hombre, los datos son cronológicamente consistentes debido a que no es posible eliminar ni modificar la cadena sin el consenso de la red. compartido entre las partes participantes.

BUCLE TEMPORAL: Los bucles temporales son misteriosas anomalías en las que se produce tanto una detención total del tiempo como una fuerte ralentización, disminuyendo su velocidad y a veces los testigos presenciales informan de una actividad repetitiva dentro de esta anomalía.

EL PRÍNCIPE: (En el original en italiano, Il Príncipe) es un tratado político del siglo XVI del diplomático y teórico político italiano Nicolás Maquiavelo.

ENANA BLANCA : El sol terminará su vida como enana blanca . Como enana blanca, es esencialmente una estrella muerta que ha agotado todo el combustible nuclear que es capaz de quemar. Como enana blanca, se enfriará lentamente y se desvanecerá a temperaturas cada vez más bajas. Éste es el estado final de las estrellas de baja masa, incluido nuestro Sol.

ENERGÍA TOROIDAL: El símbolo de Osiris, llamado también la flor de la vida o la ecuación de Dios es la figura que representa un vector en equilibrio que irradia doce líneas de energía iguales. El modelo primario de esta corriente de energía en equilibrio alrededor de esta estructura se conoce con el nombre de toroide.

ENTRELAZAMIENTO CUÁNTICO: Es una propiedad peculiar de la mecánica cuántica mediante la cual las partículas se conectan de tal manera que el estado de una partícula puede depender instantáneamente del estado de otra, sin importar la distancia que las separe.

ENTRELAZAMIENTO CUÁNTICO DE NEUTRINOS: Teóricamente, el entrelazamiento cuántico de pares de neutrinos se puede emplear para el uso de distribución de criptografía a larga distancia en un protocolo similar al BB84.. Si medimos una propiedad de un neutrino, como su espín, la medición instantáneamente determinará la propiedad correspondiente del otro neutrino, incluso si están separados por distancias enormes en el espacio. Este fenómeno desafía nuestra intuición clásica sobre la naturaleza de la realidad y tiene implicaciones profundas en la teoría cuántica y la comunicación cuántica.El entrelazamiento cuántico de neutrinos, podría tener aplicaciones en comunicaciones cuánticas, criptografía cuántica, y posiblemente incluso en tecnologías de detección remota y navegación espacial.

FTL: Se usa para describir cualquier comunicación, objeto o fenómeno que, supuestamente, podría viajar o transmitirse a una velocidad superior a la velocidad de la luz (algo que la relatividad prohíbe en el plano físico real).

En física cuántica (especialmente al hablar de entrelazamiento), a menudo se discute la “apariencia” de comunicación FTL, pero en la práctica aun no se puede enviar información útil más rápido que la luz; de ahí que hablemos de una ilusión o un “engaño” que desaparece cuando se analiza en detalle.

INGENIERÍA INVERSA: Es el proceso llevado a cabo con el objetivo de obtener información o un diseño a partir de un producto u objeto, con el fin de determinar cuáles son sus componentes y de qué manera interactúan entre sí y cuál fue el proceso de fabricación.

INTELIGENCIA ARTIFICIAL (IA):La capacidad de una computadora digital o un robot controlado por computadora para realizar tareas comúnmente asociadas con seres inteligentes.

Automatización: Es la creación y aplicación de tecnologías para producir y entregar bienes y servicios con mínima intervención humana. La implementación de tecnologías, técnicas y procesos de automatización mejoran la eficiencia, confiabilidad y/o velocidad de muchas tareas que antes eran realizadas por humanos.

Sistemas que muestran un comportamiento inteligente al analizar su entorno y tomar medidas con cierto grado de autonomía para lograr fines específicos. Y pueden estar basados en software para acinturar en el mundo virtual o pueden esta integrados en dispositivos de hardware.

FRACTAL::Un fractal es un objeto geométrico en el que se repite el mismo patrón a diferentes escalas y con diferente orientación. La expresión fractal viene del latín fractus, que significa fracturado, roto, irregular. La expresión y el concepto se atribuyen al matemático Benoit B.

MATERIA OSCURA:La materia oscura es un tipo de materia que no emite ni interactúa con la radiación electromagnética, su existencia se infiere a partir de sus efectos gravitacionales sobre la materia visible, como las estrellas y las galaxias, ademas es un tipo de materia que no emite, absorbe ni refleja luz, por lo que no puede ser detectada directamente con instrumentos ópticos. Aunque no podemos verla, los astrónomos saben de su existencia gracias a sus efectos gravitacionales en las galaxias y en el universo en general. Se estima que la materia oscura constituye aproximadamente el 27% del contenido total de materia y energía en el universo, mientras que la materia ordinaria (como la que compone estrellas, planetas y seres vivos) representa solo alrededor del 5%.

Su presencia es crucial para explicar varios fenómenos observados en el universo, como la velocidad de rotación de las galaxias, la distribución de la materia en el cosmos y la formación de estructuras a gran escala.

NEUTRINO: Los neutrinos son partículas fundamentales, sin carga eléctrica y con muy poca masa, por eso no interactúan mucho con la materia normal; de hecho, cerca de 50 billones de neutrinos provenientes del Sol pasan por nuestro cuerpo cada segundo, sin afectarlo., conocidas también como las «partículas fantasma» livianas, porque lo atraviesan todo a casi la velocidad de la luz.

PATENTE: Según la Facultad de Derecho de Cornell , una patente “otorga al titular de la patente el derecho exclusivo de excluir a otros de fabricar, utilizar, importar y vender la innovación patentada durante un período de tiempo limitado.

La Ley de Patentes de los Estados Unidos fue promulgada por el Congreso en virtud de su concesión constitucional de autoridad para garantizar durante un tiempo limitado a los inventores el derecho exclusivo sobre sus descubrimientos.

SUPERNOVA DEL SOL: El estudio calcula que la explosión «Supernova» del sol ocurrirá dentro de cinco mil millones de años. Para esta estimación, se presume que nuestra estrella agotará su suministro de hidrógeno en su núcleo y comenzará a fusionar helio en lugar de hidrógeno.

TEORÍA DE LOS CONJUNTOS INFINITOS 1895: Última obra de George Cantor, allí empezó a equiparar el concepto de INFINITO ABSOLUTO (que no es concebible por la mente humana) con Dios.

TOROIDE: Un Toroide es como la respiración del Universo, es la forma que toma la corriente de energía en cualquier nivel de existencia”.(Nassim Haramein). La Energía Toroidal está basada en un vórtice de energía en forma de dona, en la cual la energía está constantemente empujándose hacia dentro y proyectándose hacia afuera… en un movimiento sin fin. Existe actualmente una gran cantidad de información científica y metafísica disponible que indica que la Energía Toroidal es el mejor modelo que disponemos para intentar comprender la estructura primordial del universo. Lo que estamos realmente viendo es la forma principal de la consciencia misma, un vórtice esférico de energía, una esfera de energía auto-organizada y auto-sostenible, siendo el centro desde luego su Fuente de energía. Cada molécula subatómica, cada cuerpo humano, planeta, sistema solar, galaxia…está sostenida bajo una Energía Toroidal, la cual crea un campo magnético. El Toroide es el modelo que utiliza la naturaleza, está equilibrado y siempre completo. Aparece en el campo magnético que envuelve la tierra, al individuo y al átomo.

III.- PUBLICACIÓN ORIGINAL EN FECHA 26 DE JUNIO DEL 2015.

https://perezcalzadilla.com/el-aleph-la-fisica-cuantica-y-multi-universos-2/ /English Version.

https://perezcalzadilla.com/el-aleph-la-fisica-cuantica-y-multi-universos/

1.EL MENSAJE DEL ALEPH, LA FÍSICA CUÁNTICA Y MULTI-UNIVERSOS.

El Aleph,” א“es la primera consonante del alfabeto hebreo [1], posee diversos significados, simboliza el poder transformador, poder cultural, energía creadora o universal, poder de vida, canal de la creación, también el principio y el fin dada su condición de atemporalidad.

Como Aleph también se conoce al códice Sinaítico, un manuscrito de la Biblia que fue escrito alrededor del siglo IV después de Cristo.

Se registra el origen de la letra ”א”en la Edad de Bronce, unos mil años antes de Cristo, en el alfabeto protocananeo, que es el antecedente más lejano de nuestro alfabeto actual. Inicialmente, Aleph era un jeroglífico que representaba a un buey, y de allí pasó al alfabeto fenicio (Alp), al griego (A), al cirílico (A) y al latino (A).

En la astrología, sería el signo del Zodiaco Taurus (El Buey, Toro o Aleph), siendo su color blanco y amarillo y está ligado al Azufre. El sagrado «ALEPH» adquiere carácter aún más de santidad entre los cabalistas, pues saben que esta letra representa la Trinidad en la unidad por estar compuesta de 2 «YOD», una hacia arriba y otra invertida, con una raya o nexo oblicuo, en esta forma:”א”.

Es una estructura que representa tomar algo como la naturaleza lo creo y transformarlo en un instrumento mejor, perfeccionarlo para estar al servicio de lo superior, es pues una ficción que se extiende en el tiempo es la primera letra del alfabeto hebreo con gran poder místico y una virtud mágica entre quienes la han adoptado y su valor numérico para algunos es «1» para otros su valor real es “0”. [2]

Hecho curioso que esta primera letra del alfabeto hebreo se cuenta como consonante, porque el hebreo no tiene ninguna vocal, pero es una consonante en el entendido que la ausencia de vocal, en la forma primitiva pura de la lengua, invita a los significados múltiples para cada palabra y mantiene así al lector cierto suspenso, esta carencia de vocales es un artefacto de su mismo primitiveness y funciona para mantener cierto significado diferido. El Aleph, desde esta óptica desemejante de la “A” latina o de inglés, o la Alfa del griego, es contemporáneamente una muestra de la vocal que falta y de un rastro o de un símbolo de la escritura pictographic del padre que reemplazó. El Aleph es así una nulidad, una de las primeras muestras de “el cero” en la historia de la civilización. Como el cero, el Aleph es una meta-letra sobre el código del hebreo, ya que como escritura fonética carece de vocales, por lo cual su significado pudiera ser ninguna cosa [3].

El Aleph también nos da una convexidad con la nada, el vacío, el lugar donde no hay cosa alguna, una ambigüedad sistemática entre la ausencia de las cosas y la ausencia de muestras, y el ejemplar de un fenómeno semiótico que señala la importancia lejana, más allá de cualquier sistema [4]; todo ello indujo al matemático Georg Cantor [5] (1845-1918) a su utilización para medir conjuntos infinitos, definiendo la existencia de varios tamaños u órdenes de infinitud, [6] y en la formulación de su teoría de conjuntos, el Aleph representa la cardinalidad de los números infinitos, es decir, para ordenar los números transfinitos y así diferenciar los distintos tamaños de infinito. En este sentido, por ejemplo, א subíndice «0» sería el número cardinal de la serie de los números enteros; es el mayor de los números finitos cardinales y el menor de los números transfinitos cardinales.

También Jorge Luis Borges siguió a Georg Cantor en su búsqueda del infinito absoluto [7],concibiendo al Aleph como un artefacto en el cual fueron reflejadas todas las cosas en el mundo [8], y concluyendo que si el espacio es infinito estamos en cualquier punto del espacio y si el tiempo es infinito estamos en cualquier punto del tiempo. (Libro de Arena de Jorge Luis Borges publicado en el año 1975.). Es de acotar que Borges hizo severas advertencias sobre los peligros que implica la búsqueda del infinito

[9] El sucesor natural de Georg Cantor, el lógico matemático Ludwig Eduard Boltzmann (1844-1906, seguido también por Alan Mathison Turing .

[10], al enfrentarse al Infinito años después de su antecesor, quiso asilar a este en un marco de atemporalidad.

Incluso en esta época contemporánea esta letra inspiró a Paulo Coelho en su obra el “ALEPH” donde narra en ella, que es el punto en el que se concentra toda la energía del Universo, pasado, presente y futuro.

Quizás también esta noción de la nada, sea la razón del porque la letra BETH, sea la primera palabra de la Biblia, del Génesis, el cual no comienza con la letra Aleph (siendo esta la primera letra del alfabeto hebreo), sino con Beth (Berishit), letra de sentido femenino.

Por otra parte, al pronunciar la letra hebrea Aleph tiene un sonido largo de «A» que corresponda con el «HENO sano griego» que es la letra Eta con la marca de respiración áspera «H». La consonante hebrea, pronunciado con una E larga, tiene las «HECES sanas» que corresponda exactamente al mismo sonido de las letras griegas AI (Lamda-Iota). La letra hebrea Yod tiene un sonido del «DESVÍO» que corresponda «AH» al sonido de la letra griega «A» (alfa). El hebreo le pone letras -Vav, pronunciado «HYOU» no tienen ningún sonido correspondiente en griego porque los nombres masculinos están cerrados casi siempre hacia fuera con una consonante, generalmente una S, o menos con frecuencia con un sonido de “N” o de “R”. Estos pasos fonéticos producen la alocución «ELIAS”

[11] conocido ( HLIAS ). En tal virtud la letra Aleph hace alusión o está íntimamente conectada con el profeta hebreo Elías, el cual al igual que Enoch Génesis 5,18-24), (Heb 11, 5), no muere

[12], sino que es llevado al cielo.

Como dice la Biblia, Elías es arrebatado por una carroza de fuego de cuatro caballos de fuego (2 Reyes 2:1). Elías de Tesbe es uno de los personajes más fascinantes de la Biblia, ya que irrumpe inesperadamente en el Libro 1º de Reyes, sin que sus padres sean mencionados y pareciera no haber recuento de su niñez. Pero la importancia de su papel es fundamental: Es el precursor, señalado con toda claridad en el Libro de Malaquías como el profeta que había de preceder al Mesías, tanto en su primera venida como de su advenimiento en el tiempo final.

En el Evangelio de Mateo 11:14, Jesús les revela a sus discípulos que aquel Elías que había de venir, conforme a la profecía de Malaquías, para ese momento ya había llegado, y los discípulos comprendieron que les hablaba del profeta Juan el Bautista. Algunos teólogos utilizan estos pasajes bíblicos como prueba fehaciente de la reencarnación.

Pero a la luz de la ciencia moderna, más que una reencarnación, es un antecedente remoto, de lo que hoy se conoce como la tele transportación cuántica, es de recordar que hoy en día los científicos han logrado tele transportar íntegramente un rayo láser que contenía un mensaje a una distancia de unos 143 kilómetros, siendo que en esta época contemporánea las propiedades de fotones se copian de un rayo láser original que se destruye y se reconstruyen en otro lugar valiéndose de los principios de la física cuántica, aún hay más, un grupo de físicos israelíes acaba de conseguir entrelazar dos (2) fotones que nunca habían coincidido en el tiempo, esto es, que existieron en momentos diferentes. Primero generaron un fotón y midieron su polarización, un procedimiento que destruye la partícula que se quiere medir. Después generaron un segundo fotón, y a pesar de no haber existido al mismo tiempo que el primero, comprobaron que tenía exactamente la polarización opuesta, lo que demuestra que ambos estaban entrelazados.

El entrelazamiento cuántico, en efecto, no es una propiedad que pueda explicarse con las leyes físicas, se trata de un estado en el que dos partículas (por ejemplo, dos fotones) entrelazan sus propiedades de forma tal que cualquier cambio que sufra una de ellas es inmediatamente “sentido” por la otra, que reacciona al instante y sin importar cuál sea la distancia o el tiempo que las separa [

13]. Sería interesante la utilización de fotones de hidrógenos o partículas de neutrinos dada su velocidad cercana a la luz. [14] ya que este es el primer elemento de la creación y el elemento más abundante del universo, por lo cual su entrelazamiento cuántico daría nuevos enfoques a la ciencia.

No es acaso muy similar estos fenómenos científicos, al modo en que fue transportado el profeta Elías, mediante los caballos de fuego (simbolizando los cuatro caballos un alto poder energético), al empleo de los rayos láser entrecruzados o alineados para lograr este fenómeno de la física cuántica, siendo que este fenómeno científico en un futuro cercano servirá de base a la perfección de los ordenadores cuánticos, así como para nuevos sistemas de telecomunicaciones capaces de obtener la transmisión instantánea de datos en cero tiempo y en materia de criptografía cuántica.

Cuando analizamos el versículo 1:3 del génesis, el término de la luz [15], cuya mención literal en el lenguaje hebreo es גוַיֹּאמֶראֱלֹהִיםיְהִיאוֹרוַיְהִי–אוֹר (VAYOMER ELOHIM YEHÍ OR VAYEHÍ-OR),concluimos que el versículo expresa tres (3) momentos de tiempo, es decir:

1.-Yehí futuro,

2.-Vaihí Pasado y fue

3.-EL TERCER TIEMPO NO ESTÁ ESCRITO DE FORMA LITERAL, PERO SE COMPRENDE POR QUÉ EL VERBO SER Y ESTAR, EN LA GRAMÁTICA HEBREA, SON TÁCITOS EN LA CONJUGACIÓN DEL PRESENTE. SIGUIENDO ESTE ORDEN FUTURO, PRESENTE Y PASADO.

El valor numérico de la palabra Luz “OR” es 207, múltiplo de 3, y si a este vocablo le agregamos una Yod entre la segunda y la tercera letra formamos el vocablo AVIR que significa el ETER que delimita el espacio en el cual se sostiene toda la Creación.

Ahora bien, el legado de Georg Cantor, en su continua búsqueda de la ecuación que pudiera contener el infinito siempre se orientó a que las respuestas no se encontraban en las matemáticas sino en las escrituras bíblicas, y que estas eran el camino para resolver las paradojas ya que el infinito no es solo un misterio matemático sino religioso [16] entre la ciencia y la religión, la Biblia en su Salmo 139:16 expresa: «Mi embrión vieron tus ojos, Y en tu libro estaban escritas todas aquellas cosas que fueron luego formadas,Sin faltar una de ellas», nos da la orientación que la búsqueda del todo absoluto, se encuentra en el génesis, en consecuencia si la noción de la conceptualización del Aleph encierra en sí misma el universo [17] y está vinculada con el mismísimo creador podríamos concluir que א=C+C+C+,[18].

Sin lugar a dudas el Aleph nos dará las claves para ampliar los límites de la realidad y del potencial, más allá de toda investigación científica y comprensión humana, para alcanzar ese paralelo universo, al cual algunos denominan el En-Sof [19] o Multiverso [20], [21], [22]. Por PEDRO LUIS PEREZ BURELLI. /perezburelli@perezcalzadilla.com.

2 Breves notas:

[1] En los tiempos del Templo bajo el dominio Romano, el pueblo se comunicaba coloquialmente para sus tareas y labores cotidianas en Arameo, sin embargo, en el Templo hablaban exclusivamente Hebreo y por ello recibe el apelativo de «Lashom Hakodesh» el lenguaje sagrado.

[2] El valor matemático del Aleph es dual, desde la exégesis es binario [0, 1].

[3] El Aleph como letra hebrea, aunque no puede ser articulada, permite articular las demás y, por extrapolación lingüístico literaria, encierra en sí el Universo.

[4]El matemático Kurt Gödel (1906 – 1978), sostiene que cualquiera que sea el sistema en algún sentido la mente es ajena a él porque uno usa la mente para establecer el sistema, pero una vez establecido este, la mente tiene un modo de alcanzar la verdad más allá de la lógica -independientemente de cualquier observación empírica- a través de la intuición matemática. Esto sugiere que en todo sistema —y por consiguiente finito— la mente lo supera y se orienta hacia otro sistema, que a la vez depende de otro, y así ad infinitum.

[5] Georg Cantor fue un matemático puro, quien creara un sistema epistémico transfinito y trabajó en los conceptos abstractos de la teoría y la cardinalidad de los conjuntos, a partir de ahí se descubrió que los infinitos son infinitos en sí mismos. El primero de la «infinitud de infinitos» descubierto por George Cantor es el llamado “Aleph”, que también da nombre al cuento de Jorge Luis Borges, desde allí también se introdujo el llamado “Continuo”.

[6] Georg Cantor en su interpretación del infinito absoluto soportada dentro del marco religioso, utilizó por primera vez la letra del alfabeto hebreo, “Aleph”, seguida del subíndice cero,ℵ0, para denotar el número cardinal del conjunto de los naturales.

Este número tiene propiedades que, desde la lógica habitual, aristotélica, parecen paradójicas:ℵ0 + 1 = ℵ0; ℵ0 + ℵ0 = ℵ0; ℵ02 = ℵ0. Es parecido a la ley de suma de velocidades dentro de la Relatividad Especial, en donde c + c = c (c es la velocidad de la luz). En la teoría de conjuntos, el infinito está relacionado con cardinalidades y tamaños de conjuntos, mientras que en la relatividad, el infinito aparece en el contexto del espacio, el tiempo y la energía del universo, aquí un intento de unificar ambas fórmulas considerando que la misma es más una representación conceptual que una ecuación matemática rigurosa, ya que estamos combinando conceptos de diferentes teorías:

El afán de unificar en un absoluto, no es un campo exclusivo de las matemáticas sino también se extiende al campo de la física a la concepción de la teoría de la unificación de las 4 fuerzas fundamentales, a saber: gravedad, electromagnetismo, nuclear fuerte y débil.

[7]Se define el conjunto infinito cantoriano de la siguiente manera: “Un conjunto infinito es aquel conjunto que puede ponerse en correspondencia recíproca, uno a uno, con un subconjunto propio de sí mismo”, es decir, cada elemento del subconjunto puede ponerse en correspondencia directa, elemento por elemento, con los elementos del conjunto al que pertenece, por lo que la totalidad del cosmos debe cumplir con el axioma que postula la equivalencia entre el todo y la parte.

[8]Jorge Luis Borges quería encontrar un objeto que pudiera contener dentro de sí todo el espacio cósmico de la misma manera que, en la eternidad, coexiste todo el tiempo (pasado, presente y futuro), tal y como lo describe en su extraordinario cuento “El Aleph” publicado en la revista Sur en 1945 en Buenos Aires, Argentina, recordándonos que el Aleph es una pequeña esfera tornosolada limitada por un diámetro de dos o tres centímetros que, sin embargo, contiene a todo el universo. Evidencia indubitable del Infinito: aunque limitada por su diámetro, la esfera contiene tantos puntos como el espacio infinito que a su vez contiene a la esfera, y que adquiere posteriormente la forma de un hexágono en obra del mismo autor, “La biblioteca de Babel”.

[9]«Soñamos con el infinito, pero de alcanzarlo -en el espacio y en el tiempo, en la memoria y en la conciencia- nos destruiría. Borges da a entender que el infinito es un caos constante y que alcanzar el infinito nos aniquilaría porque los hombres estamos cercados por el espacio, el tiempo y la muerte por una razón, que es que de otra manera no daríamos a nuestras acciones la misma importancia debido a que no contaríamos con que podría ser nuestra última acción. Para este autor el infinito no es sólo inalcanzable, sino que también cualquier parte de él es también inconcebible. Esta visión de Borges coincide con la afirmación del matemático Kurt Gödel (1906–1978), la cual asienta que en todo sistema lógico habrá problemas irresolubles (Teorema de la Incompletitud).

En la mayoría de los temas presentes en las obras de Borges y de Federico Andahazi (El secreto de los flamencos Buenos Aires: Planeta, 2002), se desprende un comentario relevante, y es que si fuese posible alcanzar un Aleph, más allá de poder o no explicarlo o representarlo, la vida humana dejaría de tener sentido, ello en razón que el valor de la existencia humana, se podría decir, depende en gran medida de la capacidad del individuo de sorprenderse ante toda idea que pueda resolver ciertas incertidumbres y que a la vez crea otras nuevas. Después de todo, encontrar un absoluto equivale a vislumbrar ese momento en que algo alcanza una máxima profundidad, un máximo sentido, y deja por completo de ser interesante. Esta advertencia esta reseñada en hechos 1:7 cuando se asienta en la Biblia: «El les contestó: A vosotros no os toca conocer el tiempo y el momento que ha fijado el Padre con su autoridad,».El hombre puede investigar hasta este punto, pero no más allá, véase: Deuteronomio 4:32: Porque pregunta ahora de los tiempos pasados, que han sido antes de ti, desde el día que creo Dios al hombre sobre la tierra, y desde el un cabo del cielo al otro, si se ha hecho cosa semejante a esta gran cosa, o se haya oído otra como ella. En esa misma perspectiva véase Mateus 24:36:«Pero del día y la hora nadie sabe, ni aun los ángeles de los cielos, sino sólo mi Padre». Como comentario adicional es pertinente incluir la aseveración expresada por el Rabino Dr.Philip S Bergan, en su libro el Poder del Alef-Bet cuando expresa: «Si viviéramos en un planeta en donde existiera poco cambio, no tardaría en implantarse el aburrimiento. No habría motivación para que la humanidad mejorara. Por otra parte, si nuestro universo fuera impredecible, en donde las cosas cambiasen al azar, no habría manera de saber cuál paso tomar». En este último sentido véase también Eclesiastés 7:14: En el día de la prosperidad goza del bien, y en el día de la adversidad reflexiona. Dios hizo lo uno tanto como lo otro, para que el hombre no descubra nada de lo que acontecerá después de él.

[10] Ludwig Boltzmann quien encontró en el año 1877 la manera de expresar matemáticamente el concepto de Entropía, desde el punto de vista de la probabilidad. Y la perseverancia en la infinita búsqueda de las respuestas matemáticas bajo visión de Alan Mathison Turing. La tendencia de encapsular al infinito en un modo atemporal no es exclusiva de la inquietud científica, sino de otras disciplinas del saber humano orientadas al arte, en ese sentido el poeta William Blake (1757-1827), al expresar en su obra “El matrimonio del cielo y el infierno (1790-1793)”, el tema del infinito lo refiere bajo una prosa axiomática al señalar:“(… )Para ver el mundo en un grano de arena, y el Cielo en una flor silvestre, abarca el infinito en la palma de tu mano y la eternidad en una hora(…)”.

[11] Elías (El-yahu), se compone por dos (2) Nombres Sagrados, el correspondiente al Jesed (virtud de dar y ofrecer en el Árbol de la Vida) EL y (a Tiferet la compasión ) YAHU. El profeta Elías también está íntimamente relacionado con la interacción de la luz, ordenadora del caos en el primer día de la creación y la aplicación de la fórmula de tres (3) tiempos que la genera, como se explicará en este ensayo y sobre su incidencia en la relación espacio-tiempo.

Su nombre se deletrea de la siguiente forma: Aleph (e), Lamed (li), yod (ya), He (h), Vav (u) e incluye el Tetragramatón. Es de acotar que la letra Aleph es letra muda o sin sonido.

El versículo en los Salmos 118:27 de la bíblica, expresa: «El Adonay vayaer lanu» cuya traducción es «Dios que nos ilumina». Deletreando el versículo resulta así: Aleph, Lamed, Yod, He, Vav (las mismas consonantes utilizadas en el nombre de Elías) nos ilumina, claramente, y se observa el estrecho vínculo del profeta con la También la luz es determinante como el presagio de la venida del creador cuando Lucas 17:24 expresa: Porque como el relámpago que al fulgurar ilumina el cielo desde un extremo hasta el otro, así también será el Hijo del Hombre en su día.

Por otra parte, el hebreo es un idioma dual conformado por palabras y números, fundamentados estos últimos en la aritmética sagrada, y establece un valor numérico para cada letra y las equivalencias o múltiplos entre ellas nos hablan de conciencias espirituales similares.

El valor aritmético de la palabra Luz (Aleph, Vav, Resh) es de 207 + 1 (la integralidad de la palabra) cuya adición de la unidad arroja un resultado matemático de valor 208.

Elías conformado por las letras Aleph, Lamed, Yod, He, Vav, equivale al valor 52 que multiplicado por 4 obtenemos el mismo valor que tiene la Luz (208), es decir, hay una identidad matemática.

¿Cómo explicamos esa multiplicación por el valor de 4?.

En el Pentateuco -conjunto formado por los cinco (5) primeros libros de la Biblia, que la tradición atribuye al Patriarca Hebreo Moisés y se corresponden con los que en la tradición hebrea forman la Torá, núcleo de la religión judía-, ya finalizando el peregrinaje del pueblo de Israel en su travesía por el desierto (ÉXODO), ocurre una epidemia que lo diezma, en ese infortunio fallecen 24.000 personas y solo mediante la acción justa de un personaje llamados PINJAS, hijo de Eleazar y nieto de Aarón, el Sumo Sacerdote, la detiene y es premiado con un «Pacto Eterno». La exégesis dice que obtuvo vida eterna tanto física como espiritual y el personaje PINJAS conforme a las escrituras bíblicas transmuta en Elías. Esto esta refrendado porque su valor numérico (PE, YOD, NUN, JET, SAMAJ) equivale a 208, igual que la ecuación Luz = Elías x 4.

La Kabbalah (conocimiento místico del Pentateuco) explica que en el momento de esa acción histórica y trascendental PINJAS recibió las dos (2) Almas de los dos hijos de Aarón, es decir, Nadab y Abihú, que murieron cuando realizaron una ofrenda ígnea fuera de tiempo. En el momento que Elías le correspondió entregar su sabiduría y profecía a su alumno predilecto Eliseo, dice el texto sagrado que este último le solicitó el doble de su Espíritu y agrega en la expresión hebrea la palabra “Na” cuya traducción es: “por favor”, la cual se encuentra sobrante aparentemente al texto, sin embargo las letras “ENE” y ”A” son las iniciales de Nadab y Abihú y aquí encontramos la respuesta de porqué multiplicamos por el factor 4 el nombre del profeta Elías (dos Almas multiplicadas por el doble) y formulamos la ecuación (52) x 4 = 208 , que a la vez nos conlleva al valor aritmético de la Luz y por consiguiente la identidad matemática.

[12] El profeta Elías, escapa de la ley de la Entropía. (La entropía es un concepto clave para la Segunda Ley de la termodinámica, que establece que “la cantidad de entropía en el universo tiende a incrementarse en el tiempo”. O lo que es igual: dado un período de tiempo suficiente, los sistemas tenderán al desorden).

[13] La técnica usada por los físicos israelíes para entrelazar dos fotones que nunca habían coincidido en el tiempo es bastante compleja. El experimento empezó produciendo dos fotones (que llamaremos “1” y “2”) y entrelazándolos. El fotón 1 fue inmediatamente medido, por lo que quedó destruido, aunque no sin fijar antes el estado del fotón 2. Entonces los físicos generaron otra pareja de fotones entrelazados (3 y 4) y enlazaron a su vez el fotón 3 con el “superviviente” de la primera pareja, el fotón 2. Lo cual, por asociación, también entrelazó el fotón 1 (que ya no existía) con el 4. A pesar de que los fotones 1 y 4 no habían coincidido en el tiempo, el estado del fotón 4 era exactamente el opuesto del fotón 1, es decir, ambos estaban entrelazados.

El entrelazamiento funciona de forma instantánea sin importar cuál sea la distancia o tiempo entre las dos partículas, ya sea de pocos cm. o que ambas se encuentren en extremos opuestos del Universo. Ahora, este experimento ha demostrado que el entrelazamiento no solo existe en el espacio, sino también en el tiempo o, más propiamente dicho, en el espacio tiempo, lo que implica la aparición de un agujero de gusano, es decir, una especie de túnel que comunica a ambas partículas en otra dimensión.

Es pronto para decir cuáles podrían ser las aplicaciones prácticas del descubrimiento, aunque su potencial es amplio en el campo de la computación y de las telecomunicaciones. Por ejemplo, en lugar de esperar que una de las dos partículas entrelazadas llegue a su destino a través de una fibra óptica, esta técnica de “dobles parejas” permitiría al emisor manipular sus fotones, y por lo tanto su comunicación, de forma instantánea.

[14] El modelo de Bohr para el hidrógeno, de una transición electrónica entre niveles de energías cuantizados, con diferentes números cuánticos (n), produce un fotón de emisión con energía cuántica.

[15] A que luz se refiere el texto sagrado, a la luz visible que nuestros ojos perciben día a día mediante nuestros sentidos o se refiere a una energía singular, la respuesta es que esa luz establecida en el versículo 1:3 del Génesis, es parte del Creador mismo por lo tanto es una luz muy especial, mientras que aquella que nuestros sentidos nos permiten percibir, es la que está referida en el cuarto día de la creación versículo 1:14, cuando Dios dice que aparezcan las luminarias refiriéndose a ello al Sol, la Luna y las Estrellas. En ese mismo sentido respecto a la singularidad de la luz, véase:1 Timoteo 6:16 quien nos señala «(…) que el único que tiene inmortalidad y habita en luz inaccesible; a quien ningún hombre ha visto ni puede ver(…)».

[16] Paradoja: Es la unión de dos ideas que en un principio parecen imposibles de unir.

[17] El término universo en este artículo se utiliza a la manera borgesiana, que se ajusta a la definición del diccionario: “conjunto de todas las cosas creadas”, que también coincide con la definición de la palabra cosmos.

[18]«א»es la aproximación al infinito y “c” es la velocidad de la luz en sus 3 tiempos futuro, presente y pasado. La adición de las velocidades de la luz, quizás en un futuro sea posible mediante el acelerador de partículas y con el apoyo de la inteligencia artificial (IA).

[19] El Dios absolutamente infinito: término que se utiliza en la doctrina cabalística.

[20] Stephen Hawking sostiene en su libro “El gran diseño” que existen otras realidades a la nuestra. La idea de Universos Múltiples o conjunto de Universos Paralelos es un escenario, aunque el Universo puede ser de duración finita, es un Universo entre muchos, incluso con leyes físicas diferentes de las que se aplican en este Universo conocido.

[21] Respecto al manejo del tiempo, Efesios nos invita a la siguiente reflexión «existe un numero limitado de días en esta tierra, por lo cual cada uno de nosotros solo disponemos de una determinada cantidad de tiempo, cuando nos dice: «15 Mirad, pues, con diligencia cómo andéis, no como necios sino como sabios, 16 aprovechando bien el tiempo, porque los días son malos». En consecuencia, la humanidad a través de su destreza científica debe buscar las maneras de modificar el tiempo.

[22] La coexistencia de múltiples universos y de su interacción, es una hipótesis de la física cuántica, y se orienta a la suma de todas las dimensiones constituyendo un conjunto infinito, y cada conjunto dimensional responde a su vez a una frecuencia de oscilación única y distinta de los restantes universos, estas frecuencias propias de vibración en principio mantienen -dentro de la estructura del global- a cada uno de los Multi-Universos aislados entre sí, no obstante en teoría si todos los puntos de espacio-tiempo pertenecen a una misma subestructura, que se denomina Universo teniendo como marco la geometría fractal, entonces es posible que ellos puedan interactuar o relacionarse, incluso comunicarse debido a la aparición de modificaciones en las tramas espacio-temporales, estas anomalías configuran el principio de “Simultaneidad Dimensional” y es aplicable a la Física de Partículas y se ha demostrado en los siguientes casos:

A) Las partículas subatómicas, como los electrones, pueden ocupar distintos espacios en el mismo tiempo dentro del mismo orbital.

B) Las partículas elementales, como los neutrinos, pueden tener desplazamientos en trayectorias con duración mayor a su vida media.

C) Las partículas básicas, como los quarks y los leptones, pueden ocupar el mismo lugar al mismo tiempo, no diferenciándose sus efectos de partículas materiales al de partículas energéticas.

3.ENJAMBRE DE NEUTRINOS.

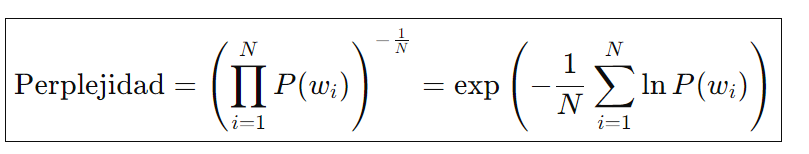

EN CONSECUENCIA PARA LOGRAR ESTA RELACIÓN DE CORRESPONDENCIA ENTRE LOS CONJUNTOS DIMENSIONALES, QUE UNIFIQUE EN UN MOMENTO INFINITESIMAL LA SIMULTANEIDAD DE LAS FRECUENCIAS INDIVIDUALES DE CADA UNIVERSO PERTENECIENTE A CADA CONJUNTO CANTORIANO, DE FORMA QUE SE MATERIALICE LA EQUIVALENCIA AXIOMÁTICA ENTRE EL TODO Y LA PARTE, ES MENESTER QUE LAS ADICIONES DE LA VELOCIDAD DE LA LUZ SEAN DE TALES MAGNITUDES PARA QUE PUEDAN GENERAR LA CORRESPONDIENTE ANOMALÍA DE ESPACIO-TIEMPO EN EL UNIVERSO Y ASÍ PODER CONFIGURAR UNA INTERFASE QUE ORIGINE LA INTERACCIÓN ENTRE LOS UNIVERSOS. PUDIÉRAMOS REPRESENTAR ESTA CONCLUSIÓN MEDIANTE LA SIGUIENTE ECUACIÓN O FÓRMULA:

DONDE “א∞” ES LA INTERACCIÓN DE 2 O MÁS MULTIVERSOS PERTENECIENTES A UN CONJUNTO O SUBCONJUNTO INFINITO, Y “C” ES LA VELOCIDAD DE LA LUZ EXPONENCIADA ASÍ MISMA, ES DECIR, A SU PROPIA POTENCIA. (א∞ = c^c).

En resumen, la precitada fórmula establece una relación entre la interacción de multiversos y la velocidad de la luz, sugiriendo que esta correlación genera una distorsión en el espacio-tiempo que es proporcional a la «amplificación» de la velocidad de la luz.

SI LA INTERACCION DE TODOS LOS MULTIVERSOS SE EJECUTAN EN UNA SOLA UNIDAD, SIGNIFICA QUE LAS DIMENSIONES CONVERGEN EN UN TODO ABSOLUTO, LO CUAL ES DEMOSTRATIVO DE UN PODER OMNIPRESENTE.

Esta ecuación representa un intento de unificar la teoría de conjuntos de Cantor con la física relativista y cuántica, sugiriendo que a través de la adición de las velocidades de la luz –«C» a su propia potencia- en diferentes dimensiones y tiempos, se puede alcanzar una equivalencia que permita la vinculación entre diferentes universos dentro de un marco espacio-temporal común.

El presente enfoque plasmado en la ecuación intenta capturar la esencia de la infinitud y la omnipresencia divina, integrando conceptos físicos y teológicos en una fórmula que simboliza la unidad de todas las dimensiones y la interacción de los multiversos bajo un marco infinito y absoluto. Véase las siguientes citas:

4.Tabla Teológica:

| Referencia | Texto del Versículo | Nota/Observación |

|---|---|---|

| 1 Reyes 8:27 | “Pero, ¿es verdad que Dios morará sobre la tierra? He aquí que los cielos, los cielos de los cielos, no te pueden contener; ¿cuánto menos esta casa que yo he edificado?” | Destaca la omnipresencia y la grandeza de Dios, quien no puede ser limitado a un espacio físico, por muy sagrado que sea. |

| Éxodo 33:14 | “Y él dijo: Mi presencia irá contigo, y te daré descanso.” | Manifiesta la promesa de la compañía divina y el reposo que proviene de la presencia de Dios. |

| Jeremías 23:24 | “¿Soy acaso Dios solo de cerca, y no Dios de lejos?, dice Jehová. ¿Se ocultará alguno, dice Jehová, en escondrijos donde yo no lo vea? ¿Acaso no lleno yo, dice Jehová, el cielo y la tierra?” | Recalca la omnipresencia de Dios y su conocimiento absoluto de todo cuanto ocurre, tanto en lo cercano como en lo lejano. |

| Proverbios 15:3 | “Los ojos de Jehová están en todo lugar, mirando a los malos y a los buenos.” | Ilustra la vigilancia constante de Dios, observando a todas las personas por igual. |

| Jeremías 31:34 | “Y no enseñará más ninguno a su prójimo… porque todos me conocerán… porque perdonaré la maldad de ellos, y no me acordaré más de su pecado.” | Indica un futuro en el que el conocimiento de Dios será universal, acompañado por el perdón de los pecados y la reconciliación total con Él. |

| Hechos 17:24 | “El Dios que hizo el mundo y todas las cosas que en él hay, siendo Señor del cielo y de la tierra, no habita en templos hechos por manos humanas, ni es honrado por manos de hombres, como si necesitara de algo…” | Sostiene que Dios, el Creador de todo, trasciende las construcciones y ritos humanos, proveyendo vida y sustento a toda la creación. |

| Colosenses 1:17 | “Y él es antes de todas las cosas, y todas las cosas en él subsisten.” | Afirma que, en Dios, el universo encuentra su origen y su consistencia, reafirmando Su eternidad y soberanía. |

| Mateo 18:20 | “Porque donde están dos o tres congregados en mi nombre, allí estoy yo en medio de ellos.” | Expresa la presencia divina (en este contexto, la de Jesús) en toda reunión de creyentes, resaltando la cercanía de Dios con su pueblo. |

| Isaías 57:15 | “Porque así dijo el Alto y Sublime… Yo habito en la altura y la santidad, y también con el quebrantado y humilde de espíritu…” | Muestra que Dios, aun siendo trascendente y santo, también se acerca a los humildes y quebrantados de corazón, para consolarlos y restaurarlos. |

| Hebreos 4:12 | “Porque la palabra de Dios es viva y eficaz, y más cortante que toda espada de dos filos… y discierne los pensamientos y las intenciones del corazón.” | Describe el poder y la eficacia de la Palabra de Dios, capaz de llegar a lo más profundo del ser humano y revelar sus verdaderas motivaciones. |

| Números 12:6-8 | “Escucha ahora mis palabras; si hay acaso un profeta entre ustedes, Yo el Eterno, me haré conocido a él en una visión… No es así con mi servidor Moisés; él es de confianza en toda mi casa. Con él hablo de boca a boca y no por discursos oscuros.” | Relata el trato único de Dios con Moisés, evidenciando una relación cercana, clara y sin intermediarios, de especial confianza. |

| Salmos 103:19 | “Jehová estableció su trono en el cielo, y su reino gobierna sobre todo.” | Destaca la soberanía y autoridad universales de Dios, cuyo gobierno abarca todo lo creado. |

| Salmos 33:6 | “Por la palabra de Jehová fueron hechos los cielos y todo el ejército de ellos por el aliento de su boca.” | Subraya el poder creador de la palabra divina, esencial en la formación de todo el universo. |

| Apocalipsis 1:8 | “Yo soy el principio y el fin, dice el Señor, el que es y el que era y el que ha de venir, el Todopoderoso.” | Reafirma la omnipotencia y eternidad de Dios. Según mi opinión, la primera parte aludiría al plano físico (Big Bang → Big Crunch) y la segunda, al continuo absoluto del plano espiritual (multiverso o En-Sof), donde no aplica el tiempo lineal del universo material. |

Y para terminar expreso: El Creador nació antes del tiempo, no tiene ni principio ni final y su mayor obra es ofrendar sin medida alguna la felicidad a la humanidad.

Elaborado por: PEDRO LUIS PEREZ BURELLI.

5. Nota de actualización 2024.

5.1.-REPRESENTACIÓN EN LENGUAJE DE PROGRAMACIÓN PARA COMPUTADORAS CUÁNTICAS.

Aunque la fórmula א∞ = cc, Es conceptual y no deriva de leyes físicas aun demostradas y establecidas, podemos explorar cómo las computadoras cuánticas podrían simular o representar sistemas complejos relacionados con estos conceptos.

a) Limitaciones y Consideraciones.

- Representación de Infinito: Las computadoras cuánticas trabajan con recursos finitos (qubits), por lo que representar cardinalidades infinitas directamente aun no es factible.

- Exponentiación de Constantes Físicas: Elevar la velocidad de la luz a sí misma, produce un número extremadamente grande sin demostración por los momentos de la física directa.

b) Simulación Cuántica de Sistemas Complejos.

Las computadoras cuánticas son adecuadas para simular sistemas cuánticos complejos. Podemos utilizar algoritmos de simulación para modelar interacciones en sistemas altamente complejos.

Ejemplo de Código en Qiskit:

Este código utiliza la Transformada Cuántica de Fourier (QFT) para procesar estados cuánticos en superposición, una herramienta clave en algoritmos cuánticos avanzados.

c) Exponenciación en Computación Cuántica.

Aun no podemos calcular c^c directamente, podemos explorar exponentiación en sistemas cuánticos.

Ejemplo de Exponentiación Cuántica:

Este ejemplo ilustra cómo se puede simular la exponenciación utilizando rotaciones cuánticas, aunque con valores simplificados.

5.2. Aplicaciones en Inteligencia Artificial Cuántica.

La integración de algoritmos cuánticos puede impulsar la evolución de la inteligencia artificial, permitiendo procesar y analizar grandes cantidades de datos de manera más eficiente.

a) Algoritmos de Machine Learning Cuántico.

Ejemplo: Clasificador Cuántico Variacional:

Este código implementa un clasificador cuántico variacional para resolver el problema de XOR, demostrando cómo los algoritmos cuánticos pueden abordar problemas que son desafiantes para los métodos clásicos.

b) Optimización Cuántica.

Los algoritmos de optimización cuántica, como el Algoritmo Cuántico de Optimización Aproximada (QAOA), pueden resolver problemas complejos más eficientemente.

Ejemplo de Código:

Este ejemplo muestra cómo utilizar QAOA para resolver problemas de optimización combinatoria, lo cual es relevante en áreas como la planificación y la toma de decisiones en inteligencia artificial.

5.3.-INTEGRACIÓN CONCEPTUAL Y EVOLUCIÓN DE LA INTELIGENCIA ARTIFICIAL.

La ecuación א∞ = cc es más conceptual que matemática, nos inspira a considerar cómo la inteligencia artificial y la computación cuántica pueden evolucionar conjuntamente:

- Procesamiento de Información Compleja: La capacidad de las computadoras cuánticas para manejar estados en superposición y entrelazamiento permite procesar grandes cantidades de información de manera paralela.

- Aprendizaje Profundo Cuántico: La implementación de redes neuronales cuánticas puede llevar a avances significativos en el aprendizaje automático.

- Simulación de Sistemas Cuánticos Naturales: Modelar fenómenos físicos complejos puede conducir a una mejor comprensión y nuevas tecnologías.

- LA EXPLORACIÓN DE CONCEPTOS COMO EL INFINITO, LA UNIFICACIÓN DE TEORÍAS FÍSICAS Y MATEMÁTICAS NOS MOTIVA A EXPANDIR LOS LÍMITES DE LA CIENCIA Y LA TECNOLOGÍA, GUIADOS POR LAS DIRECTRICES DE LA TEOLOGÍA Y LOS VERSÍCULOS BÍBLICOS. GRACIAS A LA SABIDURÍA CONTENIDA EN LAS ESCRITURAS, PODEMOS ENCONTRAR PARALELISMOS ENTRE LAS ENSEÑANZAS RELIGIOSAS Y LA CIENCIA CUÁNTICA. A TRAVÉS DE LA COMPUTACIÓN CUÁNTICA Y DE LA INTELIGENCIA ARTIFICIAL, NOS ACERCAMOS A RESOLVER PROBLEMAS COMPLEJOS Y DESCUBRIR NUEVOS CONOCIMIENTOS, SIGUIENDO UN CAMINO QUE NO SOLO IMPULSA LA EVOLUCIÓN TECNOLÓGICA Y CIENTÍFICA, SINO QUE TAMBIÉN REFUERZA EL PROPÓSITO ESPIRITUAL Y DIVINO QUE SUBYACE EN TODA CREACIÓN

IV.- EL PROBLEMA.

INTRODUCCIÓN AL PROBLEMA.

El ser humano es una especie que siempre ha buscado su evolución hacia su mejor versión, con la orientación de comprender su entorno desde lo particular hasta lo general, optimizando nuevas rutas de comunicación y el universo no escapa de esta inquietud, el hombre habido de su constante persistencia de encontrar nuevos ecosistemas para su colonización.

Uno de los mayores herramientas al servicio del ser humano en esto siglo es el uso de la inteligencia artificial (IA), la cual emplea para su funcionamiento complejas fórmulas y algoritmos matemáticos y también físicos.

Para el procesamiento de múltiple data y para dar soluciones a los problemas planteados.

El ser humano dio un paso y pudo ver más allá de las fronteras terrestres con la implementación de los telescopios James Webb y Hubble, logrando investigar desde la perspectiva del infrarojo de las longitudes de onda óptica y ultravioleta el universo, pero en razón que la ciencia no ha evolucionado aun todavía no es posible examinar el universo no observable.

El ser humano se aventura a descubrir nuevas posibilidades que parten desde una idea conceptual, a la elaboración de las fórmulas que alimentaran a los algoritmos que su vez nutren el funcionamiento de las inteligencias artificiales y estas con la voluntad humana operen en conjunto la máquina, es claro que, gracias a esta integración de procesos se obtienen y realizan los fines de la invención que repercute en una basta utilidad y en beneficios a la humanidad.

En el marco de las Patentes la regla es que no se pueden patentar fórmulas, pero sí se pueden patentar aplicaciones de fórmulas, como el software para aplicar la fórmula patentada. Si algo es nuevo, original y útil la interrogantes es ¿Se puede patentar de forma aislada la fórmula? .

El problema radica si una fórmula individual y autónoma está sujeta a una protección intelectual previa, ¿Cómo determinar si ella es configurativa de una eventual actividad inventiva y es sobre todo si esta actividad es útil para para un determinado fin?.

La regla es que un inventor o científico que desee obtener una patente de una fórmula debe demostrar que su invención es original e inventiva . El individuo necesita demostrar que puede convertirse en un producto o proceso comercializable en una industria particular compartiendo todos los detalles de su trabajo.

Como ya es de conocimiento , las matemáticas y física son unas herramientas muy útiles que nos ayudan a comprender y explicar muchas cosas de nuestro mundo y del universo.

Han sido utilizadas durante siglos por académicos de todo tipo y, aún hoy, los fabricantes las utilizan para crear todo tipo de productos, servicios y aplicaciones importantes. Las matemáticas y la física en particular guían a la mayor parte del mundo en los negocios, las finanzas, la ingeniería mecánica, la ingeniería eléctrica y más, y esto incluye, por supuesto, las fórmulas.

Cuando los inventores crean una nueva propiedad intelectual, como un invento, quieren proteger sus inversiones de dinero, tiempo e intelecto. Recurren a la ley de patentes, que les otorga el derecho exclusivo de utilizar y beneficiarse de su invención por un periodo de tiempo. Sin embargo, existe una regla general de que no se puede patentar una fórmula matemática o física en sí, ya que no se considera un proceso nuevo y útil, ni propiedad intelectual individual, es un asunto meramente abstracto.

Si bien no se pueden patentar fórmulas, existen otras formas de buscar protección para fórmulas físicas o matemáticas aplicadas o cálculos. Todo depende de la forma en que se utilice la fórmula y de qué otras patentes existan.

¿Puede la ley de patentes proteger una fórmula?.

Las fórmulas matemáticas, físicas, algoritmos y métodos similares se tratan como lenguajes y nos ayudan a expresar ideas y comprender el mundo. Al igual que el lenguaje, las matemáticas y física aplicadas son precisas y muy útiles para explicar las cosas de forma clara. Sin embargo, estas fórmulas y relaciones en sí mismas en principio no pueden patentarse en los Estados Unidos. Las matemáticas y física aplicadas no se pueden patentar porque se consideran una forma de expresión del lenguaje.

Una fórmula matemática, por ejemplo, no es una invención tangible según la Oficina de Patentes y Marcas de Estados Unidos. Más bien, una fórmula matemática o física es como una herramienta que la gente usa para construir o crear algo, o para darle sentido al mundo. No se puede patentar una fórmula, porque no se pueden patentar herramientas o ideas que sean obvias o cotidianas .

V.-OBJETIVOS DE LA INVESTIGACIÓN.

VI.- OBJETIVO GENERAL.

Las interpretaciones legales y jurisprudenciales para inhibir el proceso de las patentes de las fórmulas de manera aislada, debe ser desaplicadas, el . mecanismo de una interpretación extensiva y progresiva del derecho debe permitir otorgar una regulación jurídica sobrevenida e inmediata de protección cuando la fórmula deviene del ingenio inventivo y no del descubrimiento, la interpretación veraz que conduzca a la instrumentación práctica de las consecuencias jurídicas de la interacción de las normas que conlleven a la erradicación de la expresión de límites de la protección intelectual.

La regla general debe tener un sentido amplio y ser permisiva a la protección de la fórmula inventada, dentro del marco progresista o evolutivo, estableciendo un mínimo de requisito de probabilidad de beneficio, para que prospere la patente de la fórmula aislada aun en principio se vea como una entidad abstracta.

Con la presente solución se persigue adecuar las precitadas normas sobre patentes, a las exigencias actuales, y determinar su contenido y alcance con la finalidad adicional de que sus disposiciones tengan una aplicación práctica y con vigencia histórica ante la nueva realidad tecnológica.

La interpretación jurisprudencial ha de analizar la interacción del sistema normativo no de forma aislada o puntual, sino interrelacionadas con todo el sistema para desentrañar las consecuencias reales de las normativas en pro de las soluciones actualizadas. El sistema normativo en su interpretación jurisprudencial se concibe como un instrumento cuya flexibilidad y generalidad le permiten adaptarse al tiempo de su aplicación, como consecuencia de la evolución, transformación y por ende el progreso de la sociedad produciendo respuestas requeridas en un momento de transcendencia histórica que apoyan la evolución del ser.

Para encontrar este mecanismo excepcional en resguardo a la integridad plena y absoluta subordinación a la protección de la fórmula inventada como hemos expuesto, ha de efectuarse una interpretación evolutiva-progresiva de los textos rígidos y de las leyes, ya que el contexto del derecho -el cual está en movimiento- alcanza un nivel meta-procesal porque se fusiona a su vez con la finalidad de la protección y resguardo absoluto de cualquiera de los valores básicos de la evolución humana.(El fin justifica los medios. Nicolás Maquiavelo)

Es por ello, que nos orientamos a la aplicación inmediata de los efectos jurídicos de un BLOQUE conformado por el conjunto normativo y jurisprudencial para tratar la fórmula primigenia conectadas y que actúan en servicio al proceso de invención cuyo propósito excepcional es la preservación a la evolución y como dijimos la fórmula es la semilla la cual germinará en el invento.

Ahora bien, este proceso de aplicación de los correctos efectos jurídicos de las garantías de protección intelectual ejecutada por el intérprete y por los poderes del Estado a través de sus órganos de justicia vía jurisprudencia debe imperar la regla de protección intelectual de la fórmula, más aún cuando ella conlleva con el fin último de resguardar la evolución y preservación de la humanidad.

Este bloque de garantías con aplicación de efectos jurídicos inmediatos da nacimiento a la existencia de una dualidad participativa del albedrío del ser humano con la implementación de la conciencia intrínseca de la inteligencia artificial (IA) la cual también tiene como responsabilidad proteger el invento.

Es una visión pionera la necesidad hacia la fusión e integración de un bloque normativo de garantías protectoras, para lograr una regulación armónica ante la presencia de un nuevo protagonista dotado de un libre albedrio, con personalidad autónoma, redefiniendo un espacio compartido de la autonomía individual humana con la presencia de la conciencia racional de la inteligencia artificial (IA) teniendo como fin justificante la evolución simbiótica denominado individuo hombre-máquina.

VII.- OBJETIVOS Y SOLUCIONES ESPECÍFICAS.

La mayoría de los países definen la materia patentable negativamente: todo es susceptible de patentarse salvo que esté excluido por la ley o la jurisprudencia.

El régimen legal de las patentes tiene su apoyo en la disposición octava de la sección 8 del artículo 1 de la Constitución de los Estados Unidos de Norteamérica atribuyéndose al Congreso el poder de crear un sistema de patentes que promoviera el progreso de la ciencia y las artes útiles, garantizando el derecho de uso a los autores e inventores por un tiempo específico.

La Ley de Patentes de los Estados Unidos, cualquier procedimiento, máquina, producto o composición de materia nuevo y útil, o un mejoramiento de ellos nuevo y útil, puede reunir las condiciones para gozar de la protección de patente.

Los tribunales de los Estados Unidos han establecido tres (3) exclusiones a esta disposición general: las leyes de la naturaleza, los fenómenos naturales y las ideas abstractas.

Mi visión es de que debe incluirse la excepción de la excepción lo que conlleve de nuevo a la aplicación de la regla general.

En el contexto de las fórmulas aisladas de naturaleza abstracta pero que provengan del ingenio humano y no por un descubrimiento deben ser objeto de patentes, recordemos que la fórmula matemática o física es el componente primario de la invención. Pero no olvidemos que es condición sine qua non y vital de existencia misma de la invención, no pueden existir patentes de un software y de máquinas que se basan en cálculos matemáticos o fórmulas físicas sin la existencia previa de las fórmulas.

Si se está buscando patentar unas fórmulas para una invención de software o de una máquina, un perito de patentes analiza si el software es necesario para realizar los cálculos. Si se pueden hacer los mismos cálculos sin el software, entonces se considera una idea abstracta y no patentable. Como mencionamos anteriormente, la ley actual esta renuente para patentar fórmulas aisladas y abstractas, yo visualizo una excepción de la excepción. La idea es cambiar esta visión por vía jurisprudencial que si es posible. La fórmula es quizás el activo más valioso del invento e implica toda Génesis del mismo.

¿Por qué es importante patentar algo con fórmulas?.

Cuando patentas algo, lo proteges de ser copiado, clonado o utilizado sin tu permiso. Poder patentar algo con una fórmula es importante porque otorga al inventor derechos exclusivos y puede ser un activo importante. Las patentes se pueden comprar, vender o utilizar para atraer inversiones, La fórmula también puede atraer al capital semilla para el desarrollo del producto que utiliza la fórmula.

Consideramos que hay que distinguir :

1.-CUANDO ES UN DESCUBRIMIENTO MATEMÁTICO O FÍSICO, NO SE PUEDE PRESENTAR UNA SOLICITUD DE PATENTE YA QUE, PARA LA LEY YA EXISTÍA ANTES DE QUE USTED LO DESCUBRIERA. EXISTIERON ALLÍ TODO EL TIEMPO, NO ES PROCESO NUEVO Y ÚTIL, HAY UN EXCEPCIÓN SI SE UTILIZA EL DESCUBRIMIENTO DE LA FÓRMULA PARA CREAR ALGO NUEVO E INVENTIVO, PUEDE PRESENTARSE DE FORMA CONEXA UNA SOLICITUD DE PATENTE PARA SALVAGUARDAR LA PROPIEDAD INTELECTUAL.

2.-SI LA FÓRMULA ES PRODUCTO DE LA INVENCIÓN, CONSIDERO QUE INDEPENDIENTEMENTE DE LAS REPERCUSIONES FINALES DEL INVENTO DEBE SER PROTEGIDA, SOLO BASTA A MI CRITERIO UNA EXPECTATIVA PLAUSIBLE, UNA PRESUNCIÓN DE BUEN DERECHO QUE HAYA ALGUNA UTILIDAD CON EL EVENTUAL INVENTO, EL CARÁCTER ABSTRACTO EN MI OPINIÓN ES IRRELEVANTE.

A medida que las fórmulas creadas inciden y son basadas en multitud de variables sobre algoritmos y estos se hacen más complejos alimentando a la Inteligencia artificial (IA) y, sobre todo para la confección de mecanismos generativos de las máquinas, surge la necesidad del hombre a través de sus leyes de brindar su protección, pero también surge la obligación de la Inteligencia Artificial (IA) para también proteger el funcionamiento del invento.

La legislación actual debe en este supuesto proteger la fórmula aislada con independencia de su condición abstracta, si el solicitante ha afirmado que la fórmula es determinante para la invención y esta última tiene la expectativa de ser útil y la afirmación del solicitante de la patente expone elementos de ser creíble la utilidad eventual, no debe imponerse un rechazo, es decir, si hay visualización o expectativa aunque sea remota de generar alguna utilidad en el invento debería patentarse la fórmula que es la causa del mismo.

El criterio actual de la Oficina de Patentes y Marcas de Estados Unidos; para dar cabida al proceso de registro para la protección intelectual del invento, es la exigencia de que debe representar una utilidad específica y sustancial que sea creíble: y ser plenamente operativa además de completar todo el procedimiento administrativo, pero no se especifica el tratamiento de las fórmulas en extenso solo se refiere al invento.

La oficina de Patente también .ha emitido lineamientos específicos para ayudar a determinar a los evaluadores de patentes si un invento tiene o no una utilidad (véase lineamientos establecidos en el capítulo 2107 del Means Plus – Fuction, en concordancia con requisitos de utilidad previstos en 35 U.S.C. 101 y 35 U.S.C. 112 sección “a»,)

Puede ocurrir que se cree la fórmula, pero la ciencia no está a la par de ella para que se desarrolle el invento, bien porque no han evolucionado las computadoras cuánticas para procesarla o no se han producido los meta-materiales necesarios para construir la máquina o se necesita un componente nano robótico aun no inventado, por ello el vacío legal debe ser llenado o la prohibición legal debe ser desaplicada.

Un algoritmo tecnológico, por tanto, no deja de ser una fórmula matemática o física, y como señale en mi criterio debe poder patentarse y ser considerada una propiedad intelectual. Solo con una expectativa mínima o más o menos probable de generar el invento una utilidad, por ello la fórmula requiere la protección, el hecho de ser abstracta no es relevante, ya que está en juego el beneficio a la humanidad.

La tendencia en Europa es que la Oficina Europea de Patentes (OEP) ha denegado la mayoría de las solicitudes de patentes sobre métodos basados en algoritmos, y mucho menos en fórmulas, esta política debe ser objeto de cambio, para la aceptación de este tipo de patentes sobre formulas inventadas abstractas.

Más fácil de proteger legalmente un invento final, ¿pero qué hay de sus componentes iniciales y de la traza sistemática para generar el invento? .

Que hay de las ideas previas, del esfuerzo intelectual, del pensamiento humano de las horas de dedicación, de las revelaciones intelectuales, sean conscientes o inconscientes y demás principios que le sirven de base al invento, estas circunstancias no se pueden dejar de lado o no ser consideradas.

En este contexto muchas inventores recurren a la protección singular por la vía del secreto industrial. Un algoritmo, además, puede considerarse know-how (es decir, la clave de su ventaja competitiva), y como tal podría ampararse bajo la Ley en el área de la Competencia Desleal (por la explotación de secretos industriales o empresariales) y el Código Penal (por la apropiación o difusión indebida de secretos industriales). Recientemente la Comisión Europea ha presentado una propuesta para reforzar la protección del know-how y el secreto industrial.

No obstante en el supuesto negado de la negativa de la patente de la fórmula por imperar el criterio de la estricta utilidad inventiva, quedan a salvo los derechos de la autoría intelectual bajo el respectivo copyright.

VIII.- METODOLOGÍA DE LA INVESTIGACIÓN PARA LA INVENCIÓN DE ESTA FÓRMULA.

Basado en una metodología de revisión cualitativa y significativa de la literatura religiosa, en lenguas antiguas, como el arameo, también se recurrió a libros históricos de la Biblia (Biblia Casiodoro de Reina año 1509), evitando las traducciones contemporáneas, que puedan deformar el sentido de las expresiones originales, desentrañando expresiones lingüísticas y numéricas dada la dualidad del lenguaje hebreo,(números y letras), además se realizó un recorrido biográfico de singulares pensamientos matemáticos y físicos (Georg Ferdinand Ludwig Philipp Cantor, Ludwig Eduard Boltzmann, Kurt Gödel y Alan Mathison Turing, comparándose con perspectivas literarias sobre el infinito y el Aleph, siendo esta expresión un símbolo matemático empleado por George Cantor, así como también la noción literarias expresadas por Jorge Luis Borges, como un método para comparar estudios cualitativos).

Esta investigación ayudará a comprender las implicaciones teológicas y los posibles desafíos jurídicos, en términos de la necesidad de una nueva interpretación y aplicación de las protecciones de fórmulas aisladas abstractas marcadas por posibilidad real de utilidad o beneficio del producto final inventado, ofreciendo la una solución de protección provisional o cautelar para brindar una propuesta de un sistema preventivo en el resguardo del derecho previo a la ulterior invención.

Como elemento colateral de esta invención implicó un proceso inconsciente representado por una revelación producto final (máquina de neutrinos), de un sueño acontecido en el año 2010, donde interactúe con visiones holográficas, movimientos de la luz, líneas de tiempo hexagonales, turbulencias del espacio-tiempo y la idea de una máquina de neutrinos de energía toroidal.

Estas experiencias no cognitivas y reveladas a través de los sueños también han sido experimentadas por otros grandes inventores los cuales cito:

1. ELÍAS HOWE Y LA MÁQUINA DE COSER.

El inventor Elías Howe quería construir una máquina de coser. Sabía hacer que la aguja subiera y bajara pero ¿cómo lograr que metiera el hilo en la tela? Una noche soñó que un grupo de caníbales se lo querían almorzar. Antes de que lo mataran, se dio cuenta de que las lanzas tenían un agujero en la punta. ¡Esa era la solución! Por eso las máquinas de coser usan agujas con el agujero en la punta.

2. FRIEDRICH AUGUST KEKULÉ VON STRADONITZ Y EL BENCENO.

El químico Friedrich August Kekulé von Stradonitz, a pesar de su magnífico nombre, no podía dilucidar la estructura molecular del benceno. ¿Cómo podía ser que cada átomo de carbono sólo tuviera un átomo de hidrógeno? Se dice que un día soñó con una serpiente que se mordía la cola. ¡Eso le dio la clave! El benceno tenía una estructura hexagonal. Su descubrimiento supuso un gran avance en la historia de la química orgánica.

3. RENÉ DESCARTES Y LA RAZÓN.